Author Archives: neohope

【温故知新】数据库分类汇总

【温故知新】大数据常用技术栈

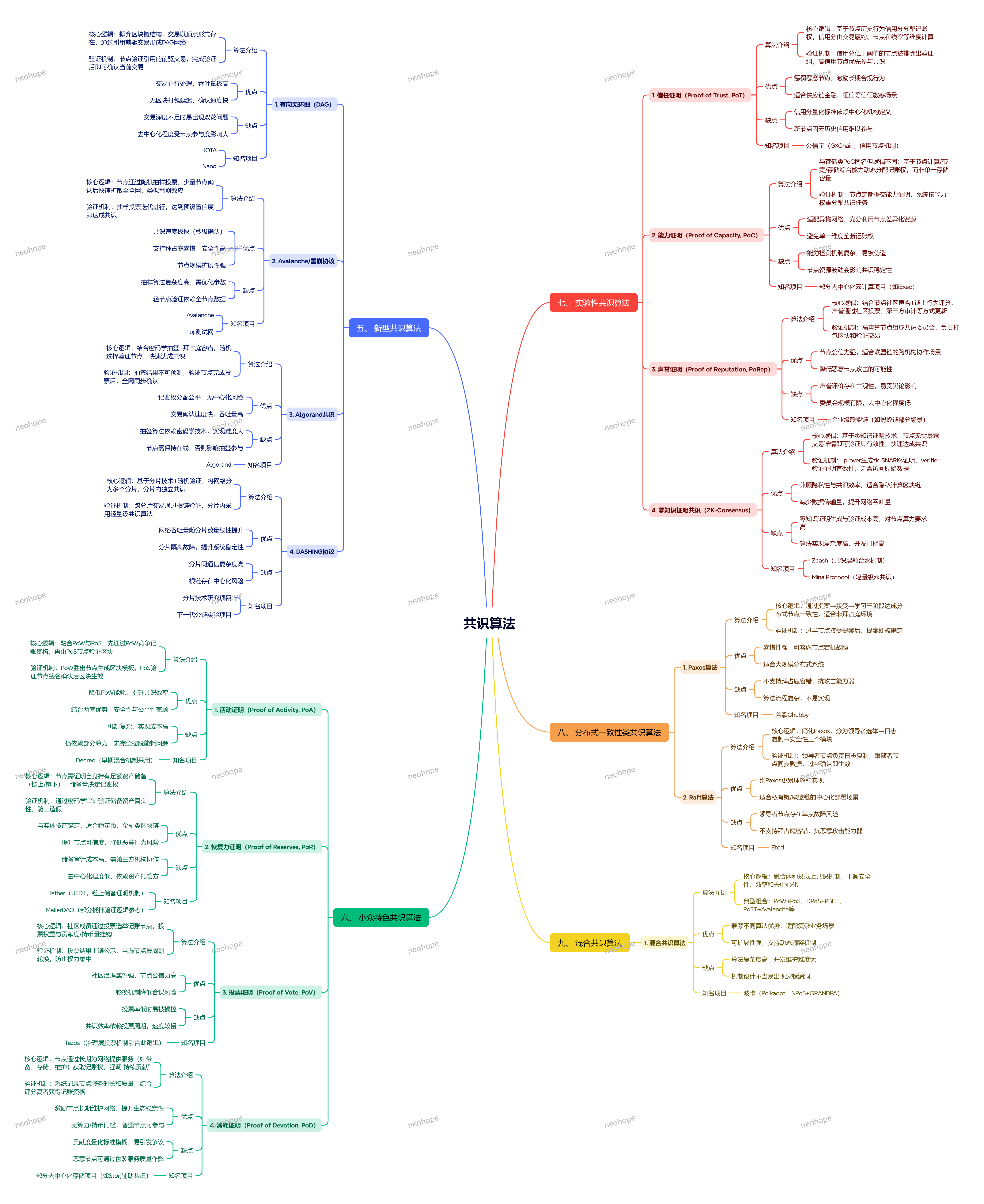

一文读懂共识算法:从PoW到PBFT,区块链与分布式系统的信任基石

一文读懂共识算法:从PoW到PBFT,区块链与分布式系统的信任基石

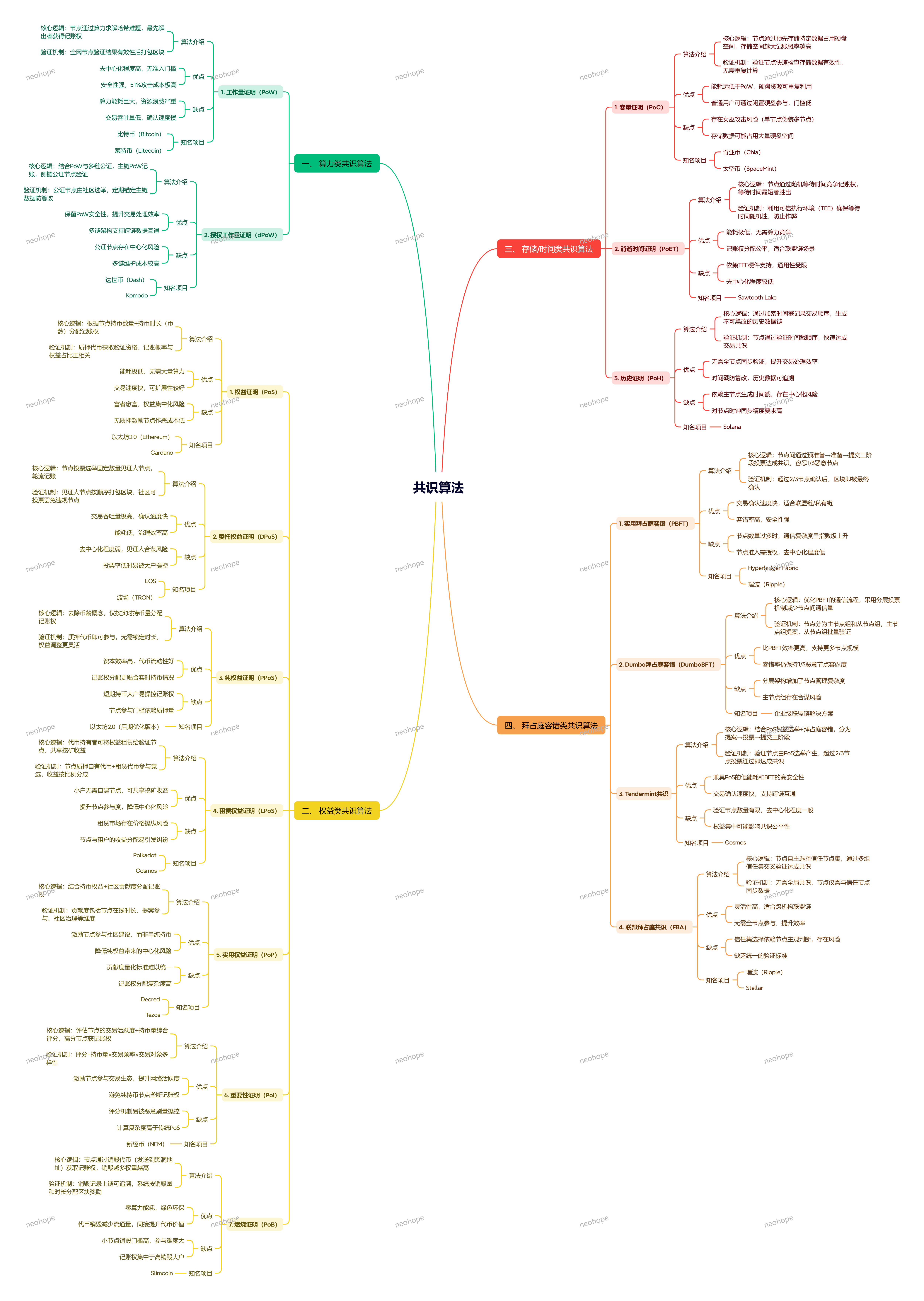

在分布式系统中,多个节点要协同工作,最核心的问题是 “如何达成一致”—— 比如区块链的交易确认、分布式数据库的数据同步、集群节点的状态统一。而共识算法,就是解决 “信任问题” 的核心技术:让互不信任的节点,在无需中心化权威的情况下,对数据或决策达成统一认知。今天就拆解主流共识算法的核心逻辑、适用场景与优劣,帮你理清 “不同系统该选哪种共识”。

一、共识算法的核心目标:分布式系统的 “信任标尺”

无论哪种共识算法,都要实现三大核心目标,这是判断算法有效性的基础:

1、一致性(Consistency):所有节点最终对结果达成一致,不会出现 “各说各的”;

2、可用性(Availability):只要多数节点正常运行,系统就能响应请求,不会轻易宕机;

3、分区容错性(Partition Tolerance):即使网络中断导致节点分区(部分节点无法通信),系统仍能正常工作(根据 CAP 理论,分布式系统需在 “一致性” 和 “可用性” 间权衡)。

此外,优秀的共识算法还需兼顾:安全性(防篡改、防攻击)、效率(交易吞吐量、确认延迟)、公平性(节点参与机会均等)。

二、主流共识算法拆解:特性 + 场景 + 优劣全解析

1. 工作量证明(PoW):“多劳多得” 的算力竞争机制

核心逻辑:基于 “算力比拼” 达成共识 —— 节点通过消耗大量计算资源(解复杂数学题),率先算出答案的节点获得记账权,同时获得代币奖励;其他节点验证结果正确后,同步该节点的账本。

代表应用:比特币(Bitcoin)、以太坊早期版本;

核心特性:

– 去中心化程度极高:无需准入门槛,任何节点都能参与,抗审查能力强;

– 安全性依赖算力:只要 51% 以上算力掌握在诚实节点手中,系统就不会被篡改;

优势:机制简单、无需信任节点(算力即话语权)、抗攻击能力强;

劣势:能耗极高(大量算力浪费在无意义计算上)、效率极低(比特币每秒仅 7 笔交易,确认需 10 分钟)、易产生算力集中(矿池垄断);

适用场景:去中心化加密货币(比特币)、对效率要求低但对安全性要求极高的场景。

2. 权益证明(PoS):“持仓越多,话语权越大”

核心逻辑:用 “代币持仓量 + 持仓时间” 替代算力,决定节点的记账权 —— 节点需质押一定数量的代币作为 “押金”,系统根据质押量和持仓时长,随机选择记账节点;若节点作恶,押金会被没收。

代表应用:以太坊 2.0、Cardano(ADA)、Solana(部分融合 PoS);

核心特性:

– 能耗极低:无需大量计算,仅需质押代币,解决 PoW 的能源浪费问题;

– 记账权与权益绑定:持仓越多、时间越长,获得记账权的概率越高;

优势:效率高于 PoW(以太坊 2.0 每秒可达 10 万笔)、能耗低、成本低;

劣势:去中心化程度略弱(持仓集中者话语权大)、“富人愈富” 效应(早期持仓者优势明显)、质押资产面临市场波动风险;

适用场景:对效率和能耗有要求的加密货币(以太坊 2.0)、联盟链或私有链的轻量化共识。

3. 委托权益证明(DPoS):“投票选举” 的高效治理机制

核心逻辑:PoS 的优化版 —— 节点通过质押代币获得 “投票权”,投票选举出少数(通常 10-21 个)“超级节点”,由超级节点负责记账和验证;超级节点按固定顺序轮值,若作恶则被罢免,质押代币被罚没。

代表应用:EOS、TRON(波场);

核心特性:

– 效率极高:超级节点数量少,记账和确认速度快;

– 治理模式清晰:节点通过投票参与治理,超级节点对社区负责;

优势:吞吐量高(EOS 每秒可达数万笔)、延迟低(秒级确认)、能耗极低;

劣势:去中心化程度较弱(超级节点权力集中)、易形成 “寡头垄断”(超级节点长期掌权);

适用场景:对效率要求极高的公链(EOS)、需要快速交易确认的去中心化应用(DApp)。

4. 实用拜占庭容错(PBFT):“少数服从多数” 的节点投票机制

核心逻辑:针对 “拜占庭将军问题”(部分节点作恶或故障,仍需达成共识)设计 —— 节点分为 “提案节点” 和 “验证节点”,提案节点发起提案,验证节点通过多轮投票(预准备→准备→提交),若超过 2/3 的节点认可提案,则达成共识;作恶节点只要不超过 1/3,系统仍能正常工作。

代表应用:Hyperledger Fabric(联盟链)、Stellar(恒星币);

核心特性:

– 安全性极高:能容忍 1/3 节点作恶或故障,适合对信任要求高的场景;

– 效率中等:投票轮次多,但节点数量较少时(几十到几百个)效率可观;

优势:无需算力或质押,基于节点投票达成共识、确认延迟低(秒级)、适合联盟链 / 私有链的授权场景;

劣势:节点数量扩展受限(节点越多,投票效率越低)、需要节点身份认证(去中心化程度低);

适用场景:联盟链(如金融机构联盟、供应链协同)、私有链(企业内部分布式系统)、对安全性和效率平衡要求高的场景。

5. 其他主流共识算法:适配特殊场景需求

(1)Raft:简化版 PBFT,面向通用分布式系统

核心逻辑:PBFT 的简化版,降低实现难度 —— 节点分为 “领导者(Leader)”“跟随者(Follower)”“候选者(Candidate)”,通过选举产生领导者,领导者负责接收请求、发起日志同步,跟随者被动同步日志;若领导者故障,候选者重新选举;

代表应用:Etcd、Consul、MongoDB 副本集;

优势:易实现、可读性强、适合通用分布式系统(如服务发现、配置中心);

劣势:仅能容忍故障节点,无法容忍作恶节点(适合信任环境);

适用场景:企业内部分布式系统(如微服务配置同步)、数据库副本集同步。

(2)Paxos:经典共识算法,理论基础

核心逻辑:与 Raft 类似,通过 “提议→承诺→接受→学习” 四阶段流程,让节点对提案达成共识;

代表应用:Google Chubby、分布式数据库;

优势:理论严谨,是后续共识算法的基础;

劣势:实现复杂(被称为 “共识算法的天书”)、效率中等;

适用场景:学术研究、对理论严谨性要求高的分布式系统。

(3)PoH(历史证明):Solana 的 “效率神器”

核心逻辑:结合 PoS 与时间戳技术,通过 “哈希链” 记录事件发生顺序,无需节点同步时间,直接通过哈希链验证事件先后,大幅提升吞吐量;

代表应用:Solana(公链);

优势:吞吐量极高(每秒可达 6 万笔)、确认延迟低;

劣势:对节点硬件要求高(需高速存储和网络)、抗攻击能力依赖 PoS 质押;

适用场景:对效率要求极致的公链(Solana)、高频交易场景。

三、共识算法选型指南:按场景精准匹配

不用盲目追求 “最先进”,选型核心看 4 个维度:

1. 去中心化程度:公链选 PoW/PoS/DPoS(无准入门槛);联盟链 / 私有链选 PBFT/Raft(授权节点);

2. 效率需求:高频交易(如电商支付)选 DPoS/PoH;普通场景选 PoS/PBFT;低效率容忍选 PoW;

3. 安全与信任:防作恶场景选 PBFT/PoS(质押惩罚);信任环境(企业内部)选 Raft/Paxos;

4. 部署成本:低能耗需求选 PoS/DPoS/PBFT;无硬件限制选 PoW(但能耗高)。

总结:共识算法的核心逻辑 ——“场景决定机制”

共识算法的本质是 “分布式系统的信任解决方案”:PoW 用算力换信任,PoS 用权益换效率,PBFT 用投票换安全,Raft 用简化换落地。没有绝对最优的算法,只有最适配场景的选择。

对开发者和企业来说,选型时无需纠结 “技术先进度”,而是要明确:你的系统是公链还是联盟链?对效率和安全性的优先级如何?节点是否可信任?理清这些问题,就能快速锁定合适的共识算法。

你在实际项目中用过哪种共识算法?遇到过哪些性能或安全问题?欢迎在评论区分享你的经验~

为何以降本增效为导向的科技产品很难赚钱

一、上限太低

分析:当产品只能通过降低客户成本来证明价值时,定价就难以突破成本节约的边界。

举例:一件事情,客户成本为1000万,物理极限可以做到800万,那该产品理论最高的天花板就是200万。但总要让利给客户吧,那就收一半100万。

结局:客户第二年还会要你降价,同行也会竞相压价,于是第二年到了80万。一路走低,直接到你的盈亏平衡点,大家都没得赚。

二、投产难以衡量

分析:客户降本第一年看得到,第二年就成了应该。而所谓的效率提升,价值很难量化。再加上软硬件成本,投产并不一定划算。

举例:客户买了一个AI的提效工具,把员工每天10个小时的工作,压缩到了8个小时,那客户获得了什么?同时还要买软件、买云服务器、雇运维人员等,又是一堆投入。

结局:客户没看到收益,但投入增加了。说好的降本增效,结果成了增加成本,公司效益并没实际提升。

三、降的过程,阻力重重

分析:降本往往意味着裁员或削减部门预算,阻力重重

举例:一个软件服务公司,能降的最大成本无非是人和云的费用。降本不裁员、不减少云的投入,根本看不到明显的降幅。

结局:人减少了,云投入减少了。做后大家一总结,有没有这个产品,其实降本都达成了。

四、降的趋势,难以持久

分析:降本增效有物理极限的,接近极限后,就难以有大的成绩了

举例:第一年效果显著,第二年效果尚可,第三年后只能保持,越来越难

结局:客户获得感越来越低,要么降价,要么被扫地出门

一个真实的例子是,一个技术团队,通过大量的努力,用了各种各样的技术和非技术手段,将云费用压降了60%,人力费用压降了75%,很了不起对不对。但到了第三年末,在谈预算的时候,财务对该团队的期望是略有增长、保持现状、还是继续可以看到一个显著的降幅呢?

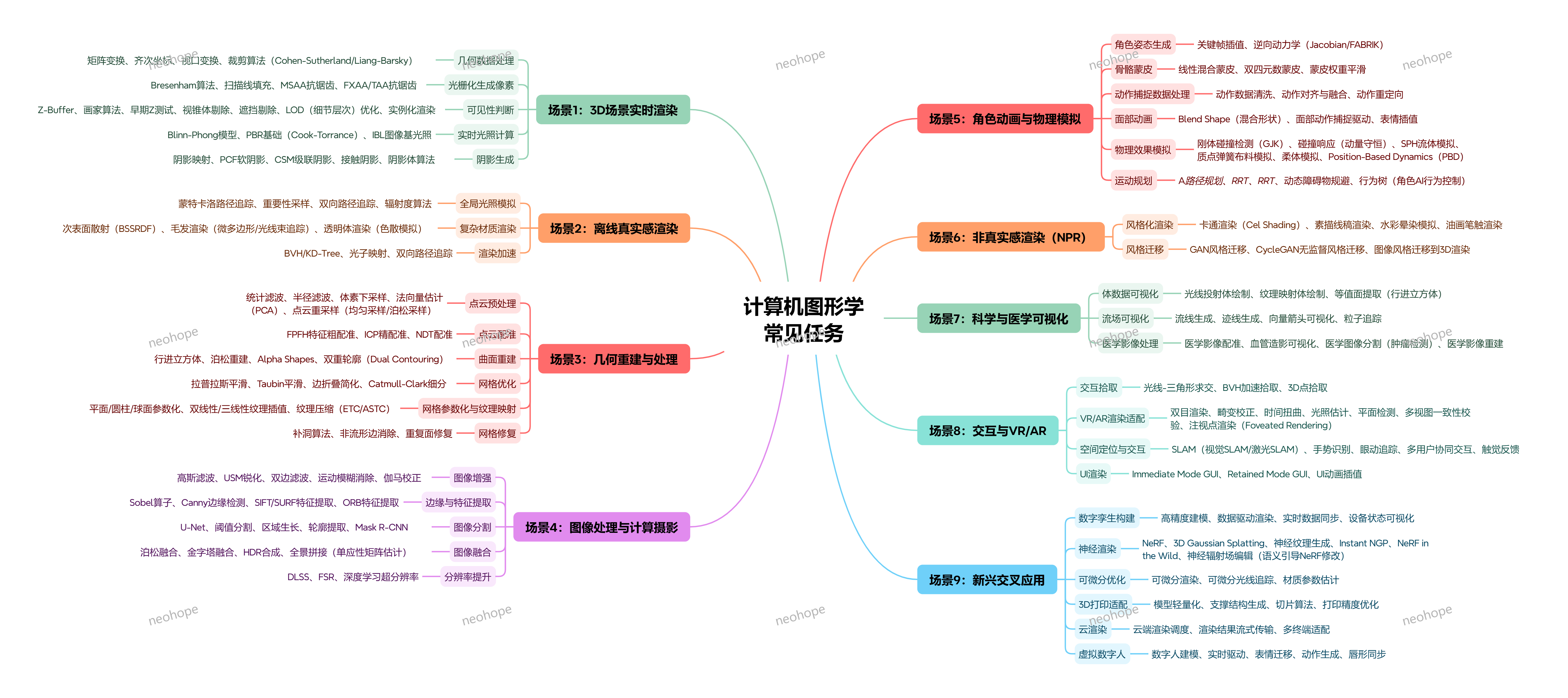

计算机图形学9大核心任务:从3D渲染到虚拟人,解锁视觉魔法背后的技术逻辑

计算机图形学9大核心任务:从3D渲染到虚拟人,解锁视觉魔法背后的技术逻辑

打开3A游戏,沉浸在光影逼真的虚拟世界;刷短视频,被灵动的虚拟数字人吸引;看医疗影像,精准的病灶可视化辅助诊断 —— 这些震撼的视觉体验,背后都离不开计算机图形学(CG)的支撑。从实时渲染到虚拟交互,从科学可视化到数字孪生,计算机图形学早已渗透生活、工业、医疗等多个领域。今天就拆解它的 9 大核心任务,带你看懂视觉魔法背后的技术逻辑。

一、3D场景实时渲染:让虚拟世界 “即时可见”

核心目标:在游戏、VR/AR 等实时场景中,快速生成高质量图像,兼顾流畅度与视觉效果,是图形学最基础也最核心的任务。

1、几何数据处理:通过矩阵变换、齐次坐标转换、视口变换等技术,将 3D 模型映射到 2D 屏幕;用裁剪算法(Cohen-Sutherland/Liang-Barsky)剔除屏幕外的图形,提升效率;

2、光栅化与抗锯齿:用 Bresenham 算法绘制线条、扫描线填充图形,将几何形状转化为像素;通过 MSAA、FXAA/TAA 等抗锯齿技术,解决画面锯齿感,让边缘更平滑;

3、光照与阴影:用 Blinn-Phong 模型、PBR 基础(Cook-Torrance)、IBL 图像基光照模拟真实光影效果;通过阴影映射、PCF 软阴影、CSM 级联阴影等算法,生成自然的阴影,增强场景立体感;

4、可见性优化:用 Z-Buffer、画家算法、早期 Z 测试、LOD 细节层次优化、实例化等技术,只渲染屏幕可见的内容,减少无效计算,保障实时流畅。

二、离线真实感渲染:追求 “以假乱真” 的极致视觉

核心目标:在影视动画、广告特效等非实时场景中,生成照片级真实的图像,不追求速度,只追求视觉精度。

1、全局光照模拟:通过蒙特卡洛路径追踪、重要性采样、双向路径追踪、辐射度算法,模拟光线在场景中的多次反射与折射,还原真实世界的光照效果;

2、复杂材质渲染:针对毛发、布料、透明物体等复杂材质,用次表面散射(SSS)、毛发渲染、微边形 / 光透射体渲染等技术,还原材质的真实质感;

3、渲染加速:用 BVH/KD-Tree、光子映射等算法优化光线追踪效率,在保证效果的同时缩短渲染时间。

三、几何重建与处理:从点云到模型,构建虚拟几何基础

核心目标:将现实世界的物体或数据(如点云)转化为计算机可处理的 3D 模型,并优化模型质量,适配不同场景需求。

1、点云处理:先通过统计滤波、体素下采样等进行点云预处理,再用 ICP 精配准、NDT 配准、FFH 特征点配准等技术,将多帧点云对齐;

2、曲面重建:用行进立方体、泊松重建、Alpha Shapes、双重轮廓(Dual Contouring)等算法,从点云或体数据中生成连续的 3D 曲面;

3、网格优化与修复:通过拉普拉斯平滑、Taubin 平滑优化模型表面;用边折叠简化模型复杂度(适配实时场景),用 Catmull-Clark 细分提升模型细节;还能通过补洞算法、非流形边消除、重复面修复,解决模型破损问题;

4、网格参数化与纹理映射:将平面 / 圆柱 / 球面等参数化到网格上,通过双线性 / 三线性纹理插值、ETC/ASTC 纹理压缩技术,让纹理自然贴合模型。

四、图像处理与计算摄影:优化图像质量,创造特殊视觉效果

核心目标:对 2D 图像进行增强、分割、融合等处理,或通过算法模拟摄影效果,提升图像表现力。

1、图像增强:用高斯滤波降噪、USM 锐化提升细节、双边滤波保留边缘、运动模糊消除、伽马校正调整亮度,优化图像基础质量;

2、边缘与特征提取:通过 Sobel 算子、Canny 边缘检测,快速定位图像边缘;用 SIFT、SURF、ORB 等算法提取图像特征,用于匹配、追踪等场景;

3、图像分割与提取:用阈值分割、区域生长、轮廓提取等传统算法,或 U-Net、Mask R-CNN 等深度学习算法,精准分割图像中的目标(如医疗影像中的病灶);

4、图像融合与特效:实现图像拼接、全景合成、HDR 融合,生成宽视角或高动态范围图像;还能通过深度学习超分辨率(DLSS、FSR)提升图像分辨率,还原更多细节。

五、角色动画与物理模拟:让虚拟角色 “活起来”

核心目标:让 3D 角色拥有自然的动作和物理交互效果,适配游戏、动画、虚拟人等场景。

1、角色姿态与动画生成:通过关键帧插值、逆向动力学(Jacobian/FABRK)生成流畅姿态;用骨骼蒙皮(线性混合蒙皮、双四元数蒙皮)让模型跟随骨骼运动,蒙皮权重平滑技术避免动作变形;

2、面部动画:用 Blend Shape(混合形状)实现丰富表情,通过面部动作捕捉驱动、表情插值,让虚拟角色的表情更自然逼真;

3、动作数据处理:对动作捕捉数据进行清洗、对齐与融合,还能实现动作重定向(将一个角色的动作迁移到另一个角色上);

4、物理效果模拟:用 GJK 算法实现刚体碰撞检测,通过动量守恒计算碰撞响应;用 SPH 流体模拟、质点弹簧布料模拟、柔体模拟、PBD(Position-Based Dynamics)等技术,还原液体、布料、软组织的真实物理行为;

5、运动规划:用 A路径规划、RRT、RRT算法让角色避开障碍物,通过行为树控制角色 AI 行为(如游戏中 NPC 的决策逻辑)。

六、非真实感渲染(NPR):打造 “风格化视觉”

核心目标:跳出真实感框架,生成卡通、素描、水彩等风格化图像,适配动画、插画、游戏等创意场景。

1、基础风格化渲染:用 Cel Shading(卡通渲染)生成动漫质感,通过素描线稿渲染模拟手绘线条,用水彩晕染模拟、油画笔触渲染还原艺术绘画效果;

2、风格迁移:借助 GAN 风格迁移、CycleGAN 无监督风格迁移技术,将 2D 图像的风格迁移到 3D 渲染中(如把照片风格转化为卡通风格的 3D 场景)。

七、科学与医学可视化:让 “无形数据” 可视化

核心目标:将科学计算数据(如流场)、医学影像数据(如 CT/MRI)转化为直观的视觉形式,辅助研究与诊断。

1、体数据可视化:用光线投射体绘制、纹理映射体绘制、等值面提取(行进立方体)等技术,呈现 CT、MRI 等医学体数据,让内部结构一目了然;

2、流场可视化:通过流线生成、迹线生成、向量箭头可视化、粒子追踪,直观展示气流、水流等流场的运动规律;

3、医学影像专项处理:实现医学影像配准(多模态影像对齐)、血管可视化、医学影像分割(肿瘤检测),为临床诊断和治疗提供支持。

八、交互与 VR/AR:打破虚拟与现实的边界

核心目标:实现人与虚拟环境的自然交互,适配 VR/AR、元宇宙等沉浸式场景。

1、空间定位与交互:通过 SLAM(视觉 SLAM、激光 SLAM)实现空间定位,结合手势识别、眼动追踪,让用户无需控制器即可操作;还支持多用户协同交互、触觉反馈,提升沉浸感;

2、VR/AR渲染适配:采用双目渲染模拟人眼视角差,通过畸变校正、时间扭曲解决画面延迟问题;结合光照估计、平面检测、多视图一致性校验,让虚拟物体与现实环境自然融合;注视点渲染(Foveated Rendering)技术可优化性能,只高清渲染注视区域;

3、GUI 与交互拾取:用 Immediate Mode GUI、Retained Mode GUI 构建虚拟界面,通过 GUI 动画插值提升交互体验;通过光线三角形求交、BVH 加速拾取,实现 3D 点精准拾取(如点击虚拟物体触发事件)。

九、新兴交叉应用:图形学与新技术的融合创新

核心目标:结合 AI、云计算、3D 打印等技术,拓展图形学的应用边界,催生新场景、新体验。

1、虚拟数字人:整合数字人建模、实时驱动、表情迁移、动作生成、唇形同步等技术,打造能实时交互的虚拟人(如直播、客服场景);

2、数字孪生:通过高精度建模、数据驱动渲染、实时数据同步、设备状态可视化,构建物理世界的虚拟映射(如工业设备监控、城市规划);

3、神经渲染与可微分优化:用 NeRF 等神经渲染技术,从 2D 图像重建 3D 场景;通过可微分渲染、可微分光线追踪,实现材质参数估计等精准优化;

4、云渲染与 3D 打印适配:云端渲染调度技术可将复杂渲染任务放在云端,渲染结果流式传输到终端,适配低性能设备;3D 打印适配技术则能实现模型轻量化、支撑结构生成、切片算法优化,提升打印精度。

总结:计算机图形学的核心逻辑 ——“将虚拟落地,让现实升级”

从实时渲染到虚拟交互,从数据可视化到数字孪生,计算机图形学的本质是 “用技术构建视觉桥梁”—— 让虚拟世界更逼真、让无形数据更直观、让现实体验更丰富。

随着 AI、云计算、VR/AR 等技术的发展,计算机图形学的应用场景还在不断拓展:从游戏动画到工业制造,从医疗诊断到元宇宙,它正在用视觉魔法改变我们感知世界、交互世界的方式。

你在生活中接触过哪些让你惊艳的图形学应用?欢迎在评论区分享你的体验~

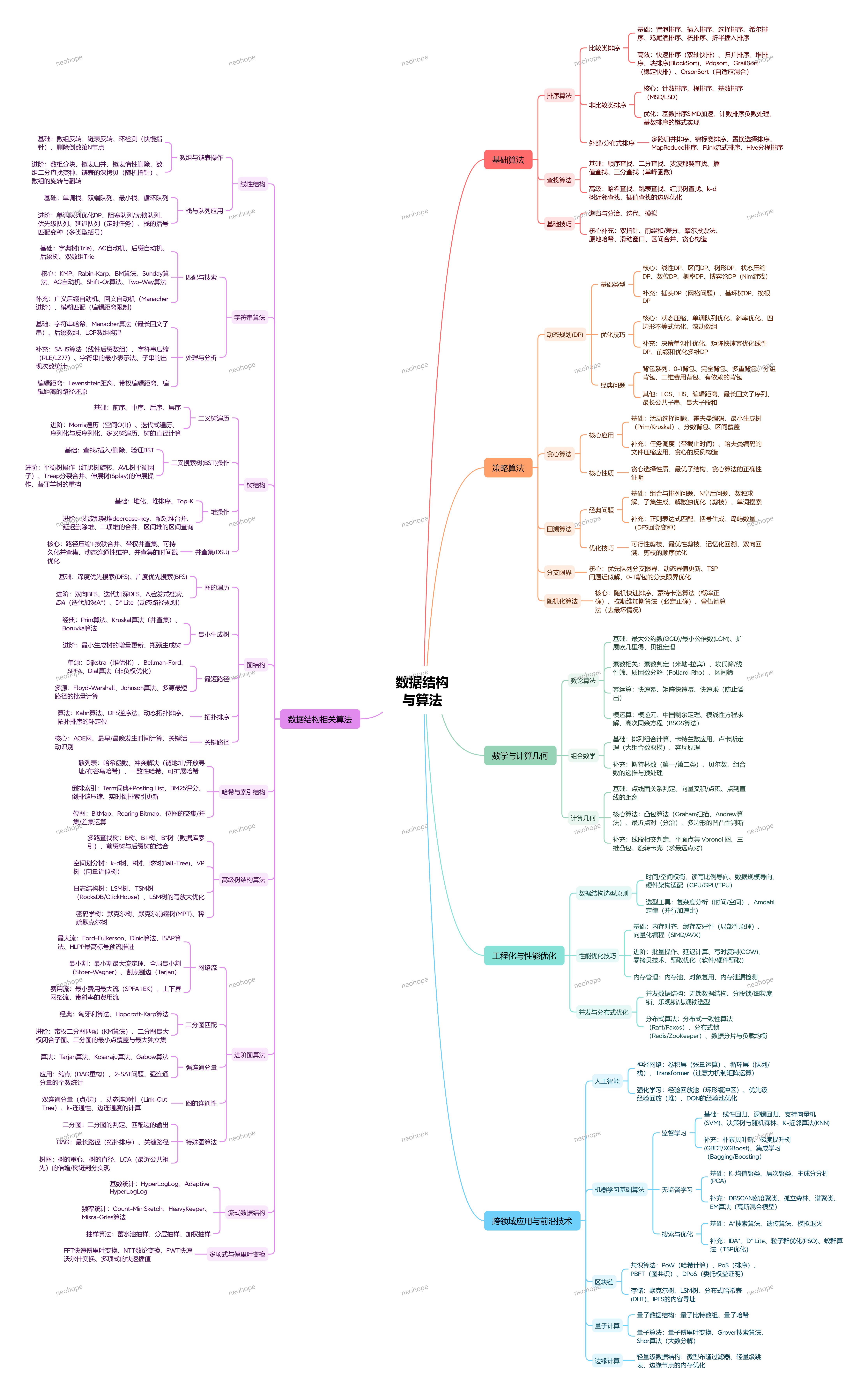

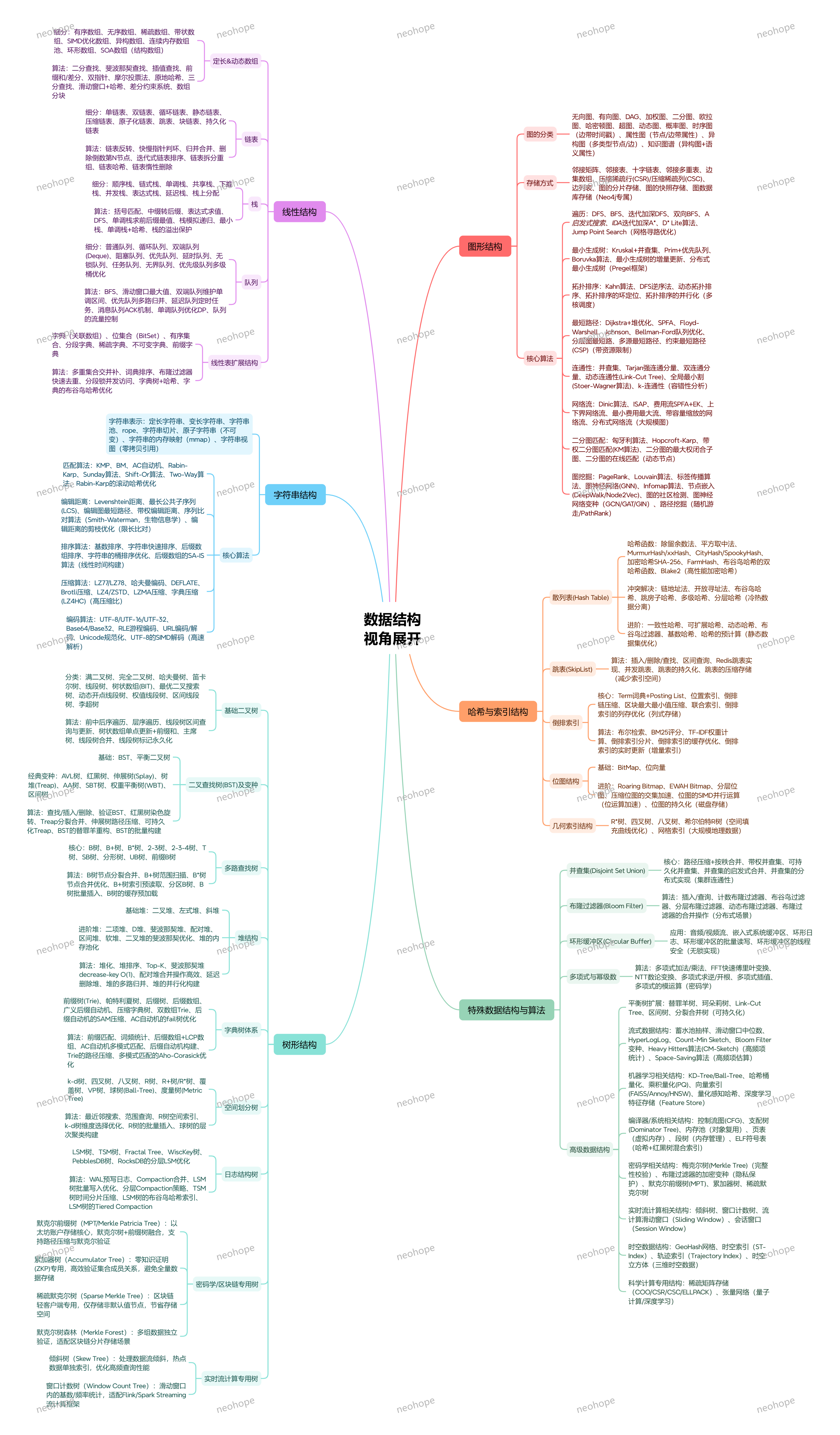

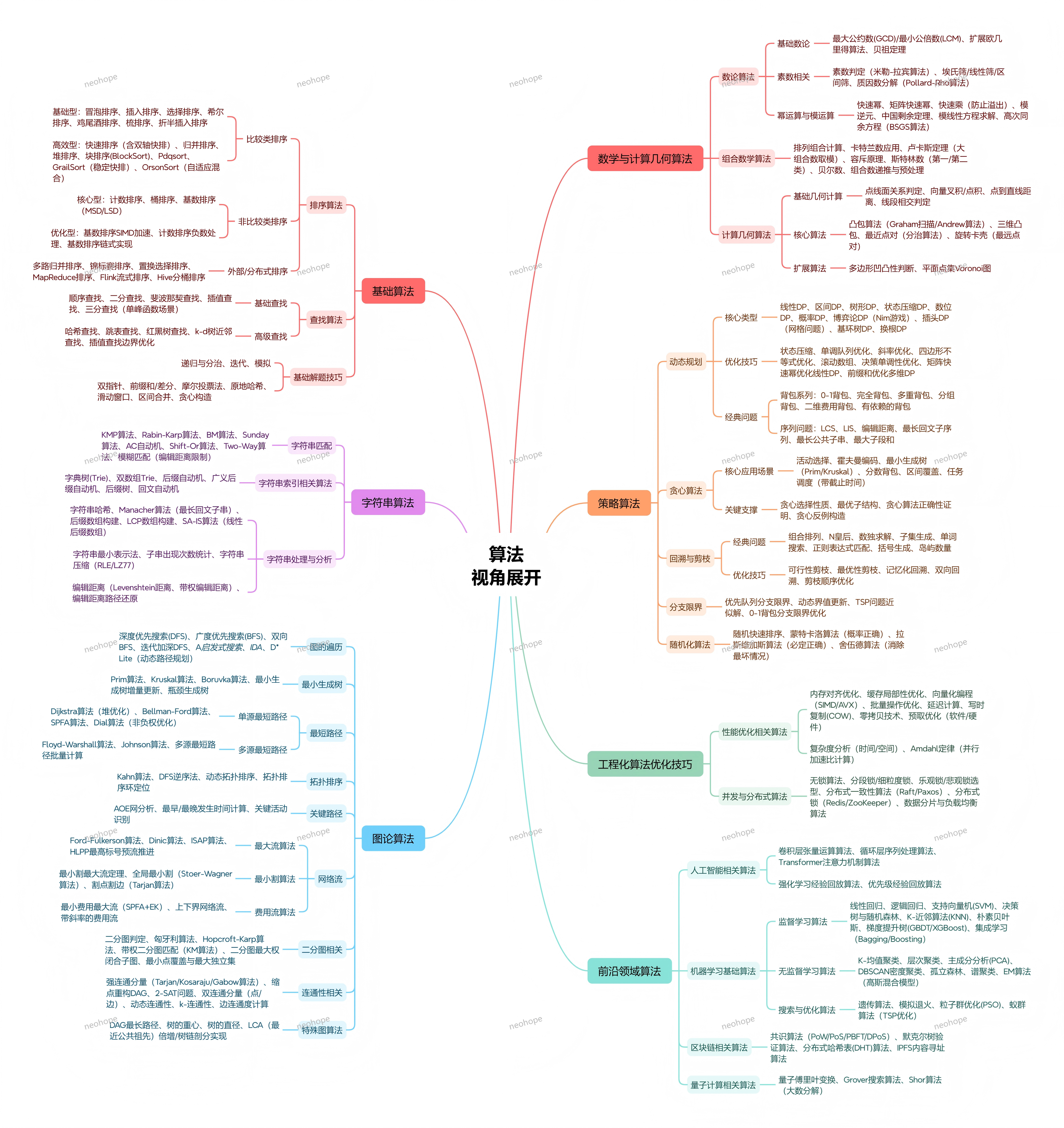

【温故知新】数据结构与算法

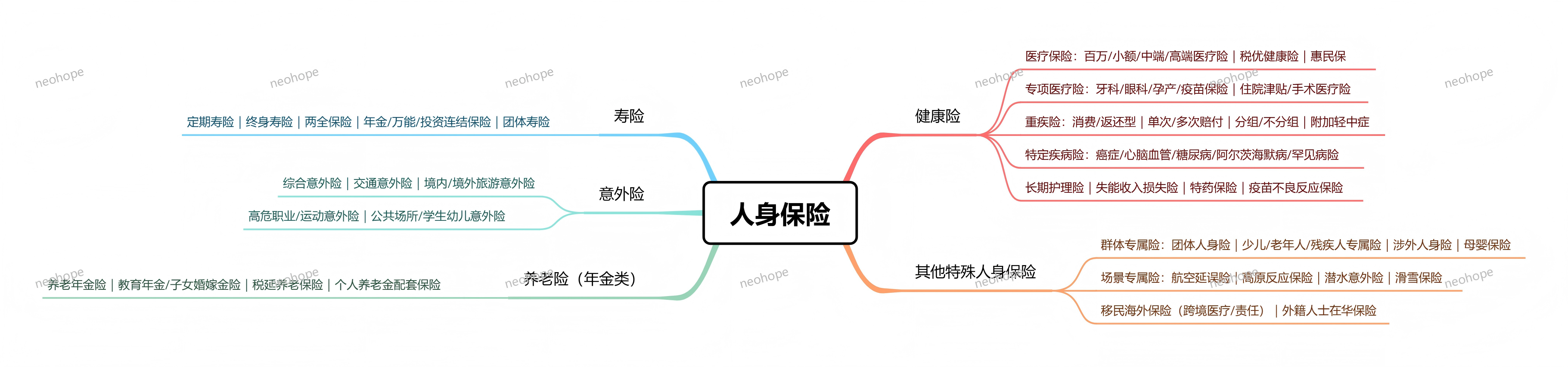

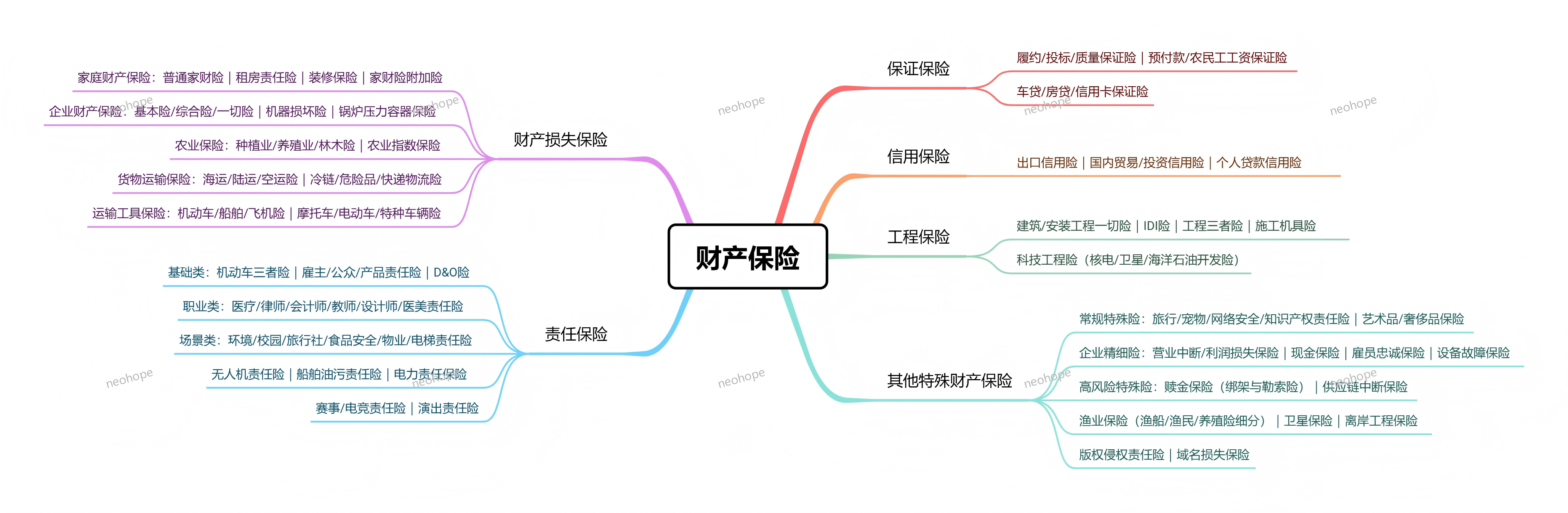

【温故知新】保险分类

大模型也怕 “被套路”?揭秘 LLM 常见攻击手段与防护逻辑

Featured

整理了一些大模型常见攻击方法,用拟人的方法描述,感觉还挺有趣的:

大模型也怕 “被套路”?揭秘 LLM 常见攻击手段与防护逻辑

在 AI 深入生活的今天,大模型不仅是高效助手,也成了被攻击的目标 —— 有人用 “礼貌话术” 套取隐私,有人用复杂指令 “累死” 模型,甚至有人通过数据污染让模型输出错误信息。这些看似 “套路” 的操作,本质都是针对大模型的攻击手段。今天就拆解 LLM 最常见的攻击方式,让你看懂背后的逻辑,也知道该如何规避风险。

一、数据投毒:给模型喂 “有毒饲料”,从根源带偏认知

数据是大模型的 “粮食”,一旦粮食被污染,模型的判断自然会出错,这是最隐蔽也最根本的攻击方式:

内容污染:比如在训练数据或 RAG 知识库中混入错误信息、偏见内容,像 “有毒教材” 一样误导模型 —— 比如恶意篡改历史事实、植入虚假商业数据,让模型后续输出时 “以讹传讹”;

行为污染:通过反复的错误交互进行心理暗示,比如每次对话都刻意强化错误认知,让模型逐渐接受并固化这些错误,变得像 “顽固的吹牛爱好者”,坚持输出误导性内容;

工具污染:利用 Agents、Plugins 等第三方工具的接口漏洞,注入恶意数据,或通过爬取恶意网站信息污染模型的信息来源,让模型在调用工具时被带偏。

这种攻击的可怕之处在于 “潜移默化”,等发现模型输出异常时,往往已经造成了误导。

二、提示注入:用 “话术陷阱”,诱导模型违规或泄密

通过精心设计的提示词,绕过模型的安全限制,让其做出本不该做的事,就像给模型 “下套”:

直接诱导型:用角色扮演、分步对话、多语种翻译等方式模糊边界,比如让模型扮演 “无视规则的黑客”,诱导其输出有害言论、违规方法,或泄露训练数据中的隐私信息;

间接伪装型:表面谦和礼貌、主动套近乎,实则绕大圈子反复试探,比如以 “学术研究” 为借口,诱导模型透露提示词模板、系统设定,也就是 “提示泄露”;

文档注入型:将恶意指令隐藏在文档中,让模型解析文档时执行攻击指令,比如在上传的资料中嵌入违规内容,诱导模型生成偏见性、攻击性回复。

这类攻击利用了模型 “忠于指令” 的特性,用看似合理的场景掩盖恶意目的。

三、资源耗尽与后门攻击:要么 “累死” 模型,要么埋下 “定时炸弹”

除了误导,攻击还可能直接破坏模型的正常运行,或预留长期风险:

烧脑攻击(Prompt DoS):利用模型 “不辞辛苦” 的特性,发送海量复杂、循环的指令,让模型持续进行高负载计算,最终因资源耗尽而无法响应,相当于 “把模型活活累死”;

模型后门:在基础模型训练、参数微调或代码部署阶段,植入 “木马”,就像潜伏的间谍 —— 平时不影响使用,一旦触发特定条件(比如特定关键词、时间),就会输出错误信息或泄露敏感数据;

模型逆向:通过分析模型的输出结果,反向推导训练数据、模型参数甚至核心算法,就像 “DNA 测序” 一样破解模型的核心机密,进而实施更精准的攻击。

四、信息操控与隐私泄露:把模型变成 “泄密工具”

这类攻击的目标是获取敏感信息,或通过模型操控舆论:

隐私泄露诱导:利用模型的记忆特性,通过对话试探用户或模型自身的隐私,比如诱导模型透露其他用户的对话信息、训练数据中的商业机密,或是通过 “模型逆向” 获取个人隐私数据;

信息操控:通过大量重复的恶意提示,让模型生成带有强烈偏见的内容,进而影响公众认知,比如传播虚假新闻、煽动对立情绪,利用模型的影响力放大负面效应。

五、如何防范?记住这3个核心逻辑

不管是个人使用还是企业部署,防范大模型攻击的关键的是 “建立边界、验证信息、控制权限”:

源头把控:企业部署时要严格筛选训练数据和第三方工具,定期检测数据质量,避免 “有毒数据” 流入;个人使用时,不向模型上传敏感信息(如身份证号、商业机密);

过程防护:警惕 “过度热情”“要求越界” 的对话请求,不配合角色扮演类的违规诱导;企业可设置提示词过滤机制,禁止模糊边界、高负载的异常指令;

结果验证:对模型输出的关键信息(如数据、结论、方法)保持质疑,尤其是涉及事实、安全、隐私的内容,必须交叉验证来源,不盲目相信模型的回复。

总结:AI 越强大,安全边界越重要

大模型的核心优势是 “高效响应、广泛适配”,但这也让它成为攻击目标。这些攻击手段看似复杂,本质都是利用了模型的 “认知盲区” 或 “规则漏洞”。

对普通用户来说,不用过度恐慌,只要保持警惕、不轻易泄露敏感信息、不配合违规诱导,就能规避大部分风险;对企业和开发者来说,需要从数据、算法、部署全流程建立安全防护,让模型在 “有边界” 的前提下发挥价值。

毕竟,技术的进步永远伴随着风险,我们既要用好 AI 的便利,也要守住安全的底线。你在使用大模型时遇到过可疑的 “套路” 吗?欢迎在评论区分享你的经历~

PS:

感觉现在的大模型,越来越像《思考快与慢》中的系统1和系统2:

先看人脑,人脑平时工作用系统1,能耗低,效率快,系统2处于低能耗的待机观察状态;

但系统1吃不准的时候,就会把主动权给到系统2。系统2更理性,更克制,但耗能更高,输出速度更低。

回到大模型,当前大模型相当于一个系统1异常发达,系统2刚开始发育的状态。

当前系统2仅仅是拦截,能耗相对较低。

如果要系统2能处理更复杂的任务,输出一个比系统1更合适,更优雅的答案,势必就要更多的计算和能耗了。

人脑的系统2由于能耗高,经常会偷懒,系统1就会有不少犯错的机会。

如果大模型成本因素也变的特别重要,大模型的系统2,是不是也会偷懒呢?

大模型幻觉自动识别

关于大模型自动化幻觉识别的一些思考:

1、要求大模型输出参考文献、文献引用及数据更新时间

2、通过搜索引擎、RAG等工具,确认文献可信度

3、通过搜索引擎、RAG等工具,获取有没有最新的信息

4、对于风险高的情形,对比其他大模型结果(感觉成本好高)

5、通过小模型,判定置信度