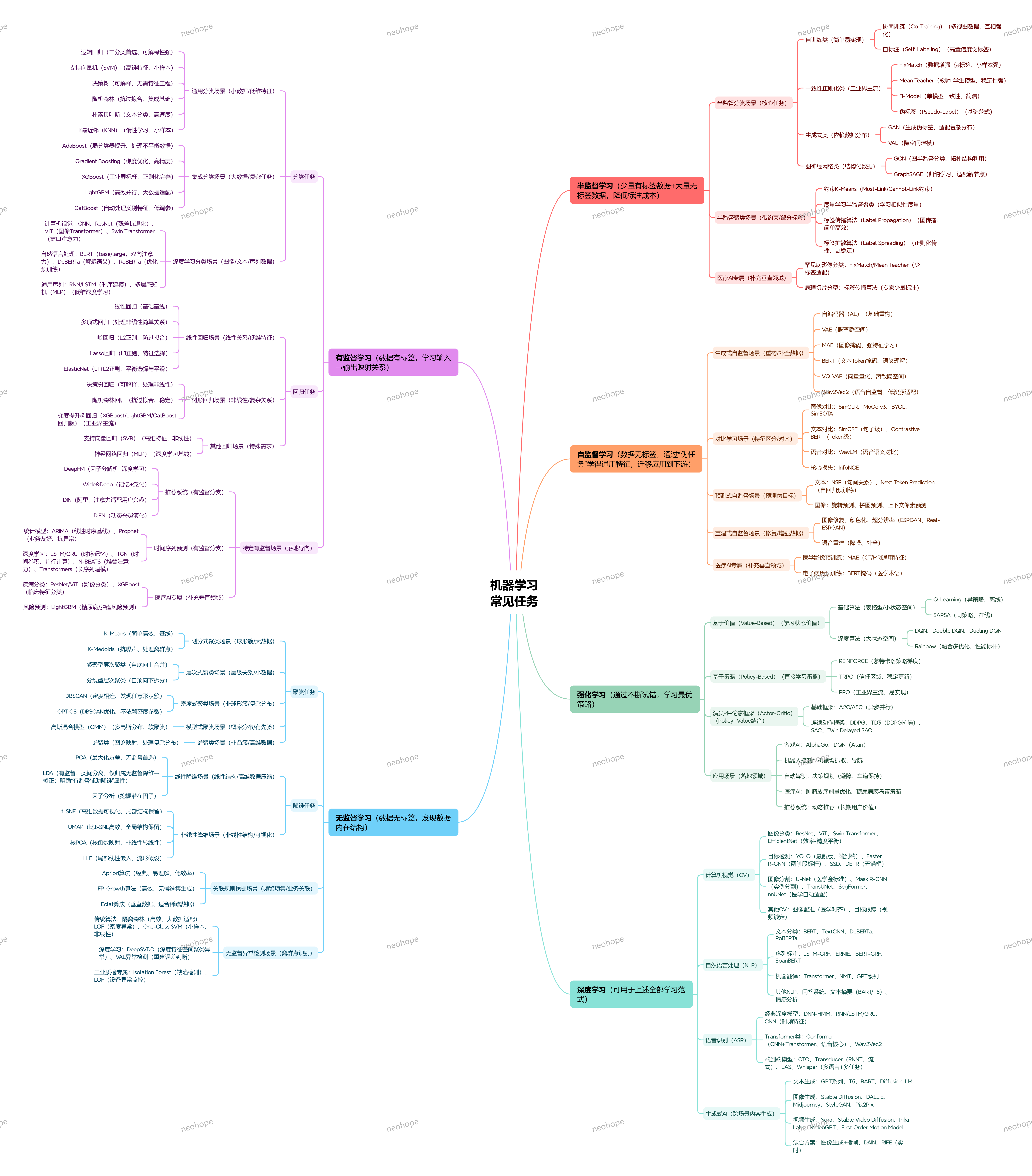

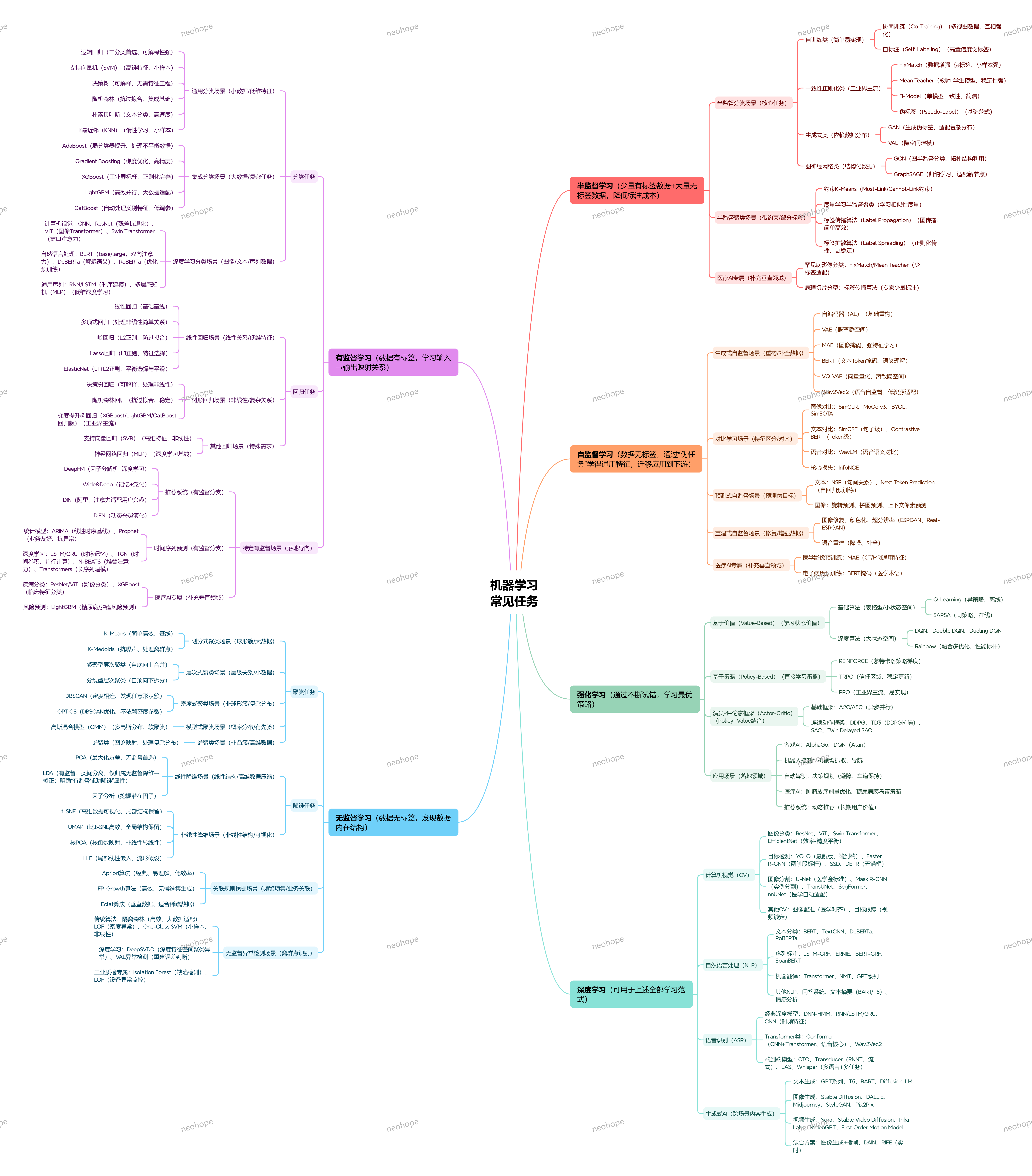

一文理清机器学习核心任务:从分类回归到生成式AI,场景+算法对应全攻略

做机器学习项目时,你是否也曾陷入 “算法太多选不清” 的困境?“二分类该用逻辑回归还是 SVM?”“推荐系统选Wide&Deep还是DIN?”“医疗影像任务该优先试MAE还是U-Net?” 其实答案很简单:任务决定算法,场景匹配工具。

机器学习的核心逻辑是 “用算法解决特定问题”,不同任务对应不同的算法体系。今天就拆解机器学习的8大核心任务、N 类细分场景,以及配套的主流算法,帮你快速找准 “任务 – 算法” 的匹配逻辑,避免盲目选型。

一、分类任务:给数据 “贴标签”,最基础也最常用

核心目标:根据输入数据,判断其属于哪个预设类别(如 “垃圾邮件 / 正常邮件”“良性肿瘤 / 恶性肿瘤”),是机器学习最经典的任务。

1、通用分类场景(小数据 / 低维特征):

二分类首选:逻辑回归(可解释性强,适合 baseline);

高维特征 / 小样本:支持向量机(SVM);

文本分类 / 高速场景:朴素贝叶斯(速度快,对文本适配性好);

可解释性需求:决策树(无需复杂特征工程,结果直观)。

2、集成分类场景(大数据 / 复杂任务):

工业界标杆:XGBoost(正则化完善,抗过拟合)、LightGBM(高效并行,适配大数据);

不平衡数据处理:AdaBoost(弱分类器迭代提升,聚焦难分样本);

稳定可靠之选:随机森林(集成多棵决策树,降低过拟合风险)。

3、半监督分类场景(少量标签 + 大量无标签数据):

基础范式:伪标签(Pseudo-Label,用模型预测无标签数据作为伪标签);

工业界主流:一致性正则化类(如 Mean Teacher,教师 – 学生模型,稳定性强);

多视图数据:协同训练(Co-Training,不同视图模型互相标注);

结构化数据:图神经网络类(GCN、GraphSAGE,利用拓扑结构提升效果)。

4、医疗AI专属分类:

病理切片分型:标签传播算法(仅需专家少量标注,降低标注成本);

疾病分类:ResNet(影像分类)、XGBoost(临床数据分类)。

二、回归任务:预测 “连续值”,搞定量化需求

核心目标:根据输入数据预测连续型结果(如 “房价多少”“未来气温”“用户消费金额”),与分类任务的 “离散标签” 形成核心区别。

1、线性回归场景(线性关系 / 低维特征):

基础基线:线性回归;

防过拟合优化:岭回归(L2 正则)、Lasso 回归(L1 正则,支持特征选择)、ElasticNet(L1+L2 正则,平衡选择与平滑);

非线性简单关系:多项式回归。

2、其他回归场景(非线性 / 复杂需求):

可解释性需求:决策树回归;

抗过拟合:随机森林回归;

高维特征/非线性:支持向量回归(SVR);

深度学习基线:神经网络回归(MLP);

推荐/广告场景:DeepFM(因子分解机 + 深度学习)、Wide&Deep(记忆 + 泛化)、DIN(阿里出品,适配用户兴趣)。

3、特定有监督场景(落地导向):

时间序列预测:基于有监督分支算法(如 ARIMA + 机器学习融合);

风险预测:LightGBM(疾病 / 肿瘤风险预测,适配医疗数据)。

三、聚类任务:给无标签数据 “找组织”,发现隐藏规律

核心目标:无需标签,让算法自动将相似数据归为一类(如 “用户分群”“异常检测”),属于无监督学习的核心任务。

1、划分式聚类场景(球形簇 / 大数据):

基础基线:K-Means(简单高效,适合球形分布数据);

抗噪声优化:K-Medoids(用簇中心替代均值,对离群点更稳健)。

2、层次式聚类场景(层级关系 / 小数据):

自底向上:凝聚型层次聚类;

自顶向下:分裂型层次聚类(适合需要层级结构的场景,如生物分类)。

3、密度式聚类场景(非球形 / 复杂分布):

经典算法:DBSCAN(基于密度相连,能发现任意形状簇);

优化版:OPTICS(DBSCAN 改进,不依赖密度参数)。

4、模型式聚类场景(概率分布 / 有先验):

软聚类首选:高斯混合模型(GMM,支持多高斯分布,输出概率归属)。

5、半监督聚类场景(带约束 / 部分标签):

约束类:约束 K-Means(Must-Link/Cannot-Link 约束,贴合业务规则);

图传播类:标签传播法、标签扩散法(适合图结构数据);

相似性学习:度量学习半监督聚类(学习适配数据的相似性度量)。

四、降维任务:给高维数据 “瘦身”,保留核心信息

核心目标:减少数据维度(如从 1000 维降到 50 维),去除冗余信息,同时保留关键特征(用于可视化、加速模型训练)。

1、线性降维场景(线性结构高维数据):

无监督首选:PCA(最大化方差,保留全局信息);

潜在因子挖掘:因子分析(适合存在潜在关联的高维数据)。

2、非线性降维场景(非线性结构 / 可视化需求):

局部结构保留:t-SNE(高维数据可视化神器,适合小数据);

全局 + 局部平衡:UMAP(比 t-SNE 更高效,支持大数据);

非线性转线性:核 PCA(通过核函数映射,处理非线性数据);

局部线性假设:LLE(局部线性嵌入,适合流形结构数据)。

3、应用场景:高维数据可视化(如基因数据、图像特征)、模型训练加速(减少维度降低计算成本)。

五、自监督学习任务:无标签数据的 “价值挖掘”

核心目标:无需人工标注,让模型从无标签数据中自动学习特征(如 “掩码重建”“对比学习”),是当前机器学习的热门方向。

1、生成式自监督场景(重构/补全数据):

基础重构:自编码器(AE);

概率隐空间:VAE(变分自编码器)、LVAE(层次化隐空间);

离散隐空间:VQ-VAE(向量量化,适合生成式任务);

图像强特征:MAE(掩码自编码器,医疗影像预训练首选)。

2、对比学习场景(特征区分 / 对齐):

文本领域:SimCSE(句子级对比)、Contrastive Learning(短语级对比);

语音领域:Wav2Vec(语音语义对比);

核心损失:InfoNCE(对比学习经典损失函数)。

3、预测式自监督场景(预测伪目标):

文本领域:NSP(句子关系预测)、Next Token Prediction(下一个 token 预测,如 BERT);

图像领域:旋转预测、拼图预测、上下文像素预测。

4、重建式自监督场景(修复 / 增强数据):

图像修复:颜色化、超分辨率(ESRGAN、Real-ESRGAN);

语音重建:降噪、补全;

文本重建:掩码恢复(如 BERT 的 Token 掩码)。

六、强化学习任务:让智能体 “试错中成长”,适配动态场景

核心目标:通过 “智能体与环境交互→获得奖励 / 惩罚→调整策略”,学习最优行为(如 “游戏通关”“自动驾驶决策”)。

1、基础算法(表格型 / 小状态空间):

异策略(离线学习):Q-Learning;

同策略(在线学习):SARSA。

2、深度算法(大状态空间):

基于价值:DQN、Double DQN、Dueling DQN、Rainbow(融合多优化,性能标杆);

基于策略:REINFORCE(蒙特卡洛策略梯度)、TRPO(信任区域,稳定更新)、PPO(工业界主流,易实现);

连续动作框架:DDPG、TD3(DPG 去噪优化);

异步并行框架:A2C/A3C。

3、应用场景:

游戏 AI:AlphaGo(围棋)、DQN(Atari 游戏);

机器人控制:机械臂抓取、导航;

自动驾驶:决策规划(避障、车道保持);

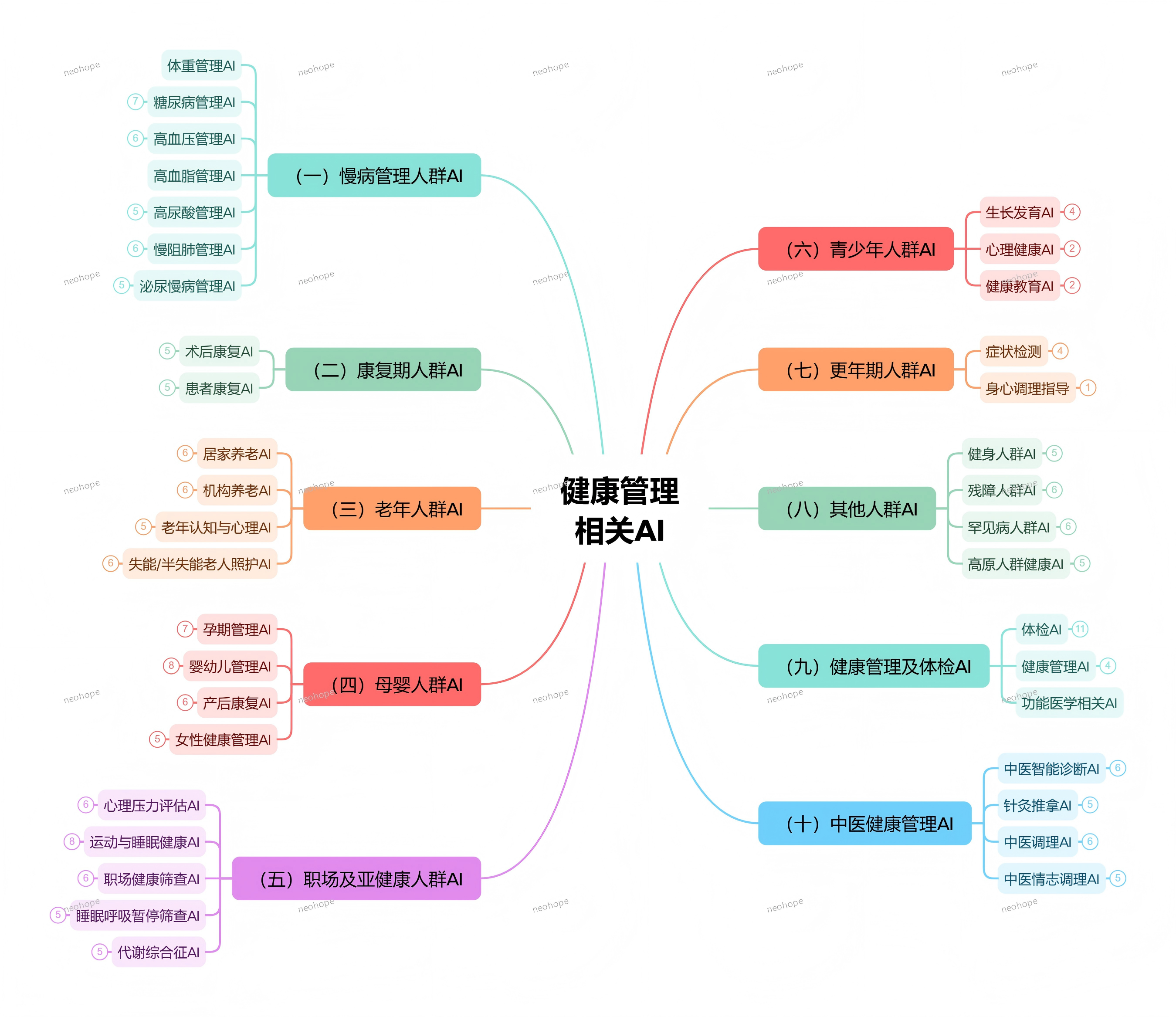

医疗 AI:肿瘤放疗剂量优化、糖尿病胰岛素调节策略;

推荐系统:动态推荐(最大化长期用户价值)。

七、生成式AI任务:“无中生有”,创造新内容

核心目标:基于数据分布生成全新的、符合逻辑的内容(如文本、图像、语音),是当前 AI 领域的热点方向。

1、文本生成:GPT 系列、T5、BART、Diffusion-LM;

2、图像生成:GAN(生成对抗网络)、Diffusion Models(扩散模型);

3、混合方案:图像生成 + 帧插值(如DALL-E+视频生成);

4、垂直领域适配:医疗影像生成(如CT/MRI模拟数据生成,辅助标注)。

八、特定有监督场景(垂直领域落地)

针对具体行业需求的定制化任务,算法与场景深度绑定:

1、推荐系统(有监督分支):DIN(动态兴趣演化)、DEN(用户兴趣动态跟踪);

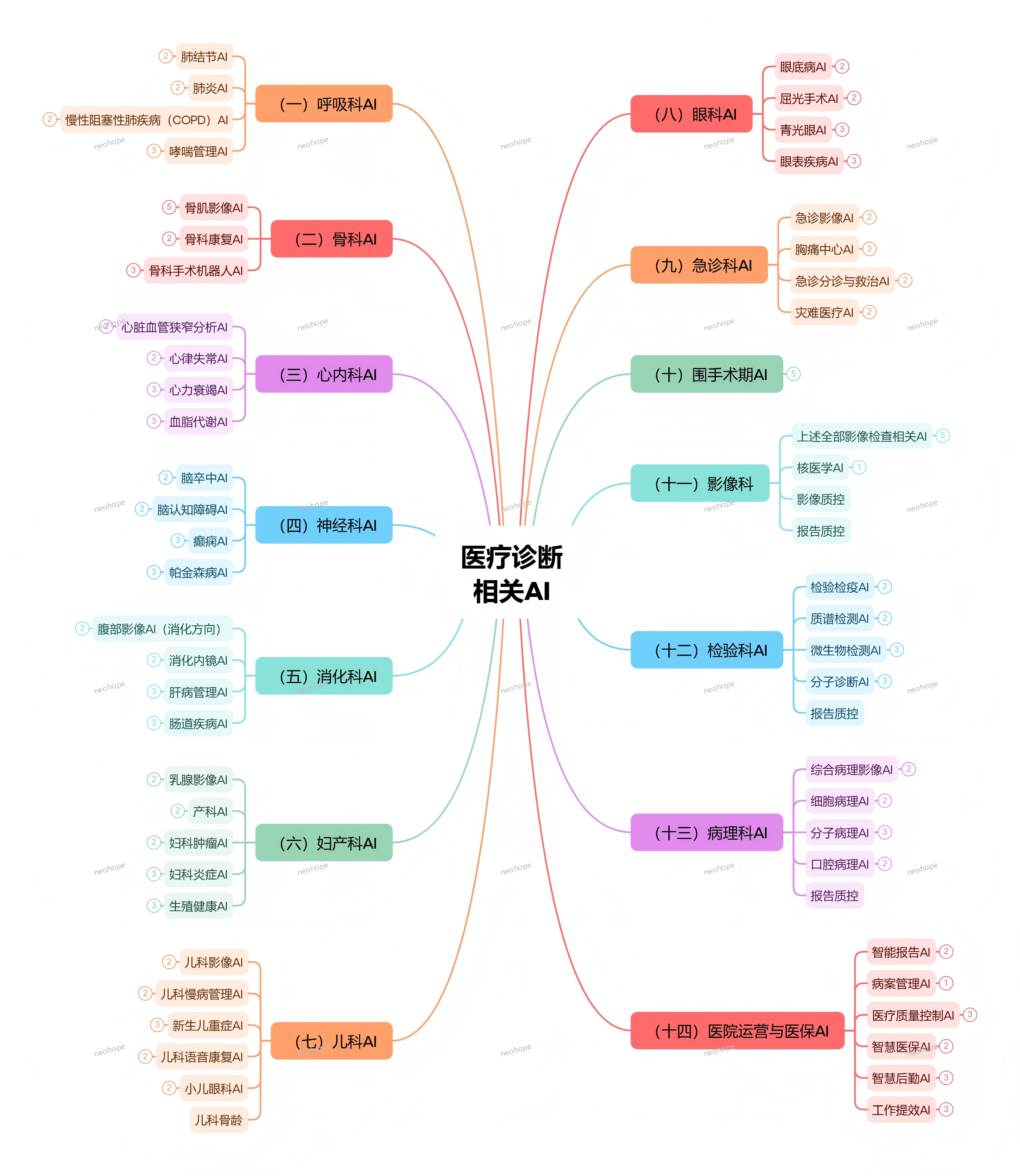

2、医疗 AI 专属:

电子病历训练:BERT(适配医学术语);

医学影像预训练:MAE(CT/MRI 通用特征提取);

疾病风险预测:LightGBM(肿瘤 / 慢病风险预测);

3、自然语言处理(NLP):

机器翻译:Transformer、NMT(神经机器翻译);

命名实体识别:LSTM-CRF、ERNIE、BERT-CRF;

问答系统、文本摘要:BERT 系列、GPT 系列;

4、计算机视觉(CV):

图像分割:U-Net(医学影像分割金标准)、Mask R-CNN;

目标检测:YOLO 系列、Faster R-CNN;

图像配准:医学影像对齐(如CT与MRI融合);

5、语音识别(ASR):CTC、Transfomer-based ASR 模型。

总结:机器学习任务选型的核心逻辑 ——“先定任务,再选算法”

不用死记硬背所有算法,选型时遵循3步走:

1、明确核心目标:是 “分类贴标签”“预测连续值”“无监督聚类”,还是 “生成内容”?

2、结合数据情况:数据量大小、是否有标签、维度高低、是否为结构化数据(表格/非结构化数据(文本/图像)?

3、匹配业务场景:是否需要可解释性?是否适配垂直领域(如医疗、推荐)?是否有实时性要求?

机器学习的本质是 “工具适配问题”,不同任务对应不同的算法工具箱。掌握了 “任务-场景-算法” 的对应关系,就能在实际项目中快速选型,少走弯路。

你在做机器学习项目时,遇到过哪些 “选型纠结”?欢迎在评论区分享你的场景和困惑~